서론

본 내용은 중앙대학교 융합보안학과(산업보안학과 대학원)의 “인공지능 규제와 신뢰성” 수업 자료입니다.

인공지능(AI) 기술이 다양한 산업과 일상 생활에 도입되면서, AI 모델이 ‘대체로’ 잘 작동하는 것은 더 이상 충분하지 않게 되었습니다. 인공지능 규제는 AI가 신뢰할 수 있고, 공정하게 작동할 수 있는 필수 요소이며, AI가 단순히 성능 향상뿐 아니라 인간 사회에서 책임감 있게 사용될 수 있는 환경을 구축합니다.

본 글에서는 국내외 AI 관련 규제 현황과 인공지능의 신뢰성에 대해 알아보고자 합니다.

국제·국내 AI 규제 현황

최근 유럽연합(EU)이 발의한 인공지능법(Artificial Intelligence Act, EU AI Act)을 비롯해, AI를 둘러싼 다양한 규제들이 본격적으로 마련되고 있습니다. AI 기술의 비약적인 발전 속도를 고려할 때, 이러한 규제 역시 끊임없이 진화하며 미래를 더욱 안전하고 공정하게 설계해 나갈 것입니다. 물론, EU AI Act 이전에도 AI 규제에 관한 논의는 꾸준히되어 왔습니다. 본 섹션에서는 AI 규제에 대한 흐름을 살펴보고자 합니다.

Principled Artificial Intelligence (2020)

Source: https://cyber.harvard.edu/publication/2020/principled-ai

하버드 대학교의 Berkman Klein Center는 사이버 공간을 탐구하고 이해하고자 하는 데에 목표가 있으며, 그 발전, 역학, 규범, 표준을 연구하고 법이나 제재의 필요성을 평가 등의 도전 과제들을 해결하는 연구 기관입니다.

Berkman Klein Center는 “AI 원칙”이 널리 퍼지고 있음에도 불구하고, 이러한 노력들을 개별적으로 또는 뚜렷한 경향이 보이는 확장되는 원칙들의 세계 속에서 맥락화하여 이해하려는 학술적 관심은 거의 없다는 것을 언급했습니다.

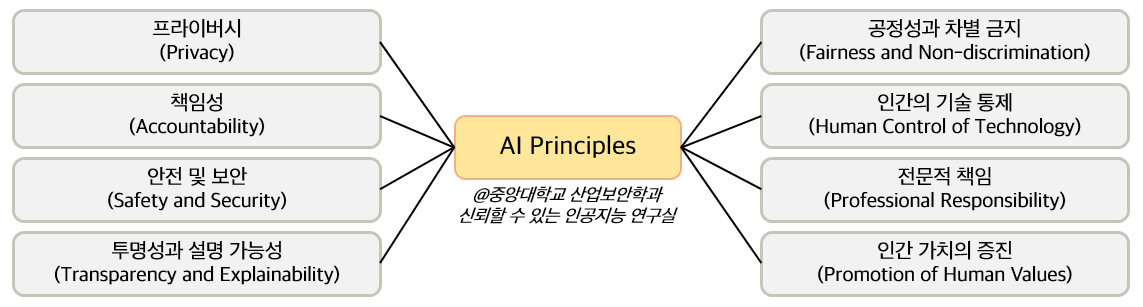

AI 원칙들에 대한 특징 추출과 분류를 위해, 본 보고서에서 36개의 주요 AI 원칙 문서의 내용을 나란히 비교하였으며, 다음과 같은 8가지 주요 주제에 대한 공통된 주제를 도출하였습니다.

8가지 주요 주제에 대한 간략한 설명은 다음과 같습니다.

- 프라이버시: 이 주제는 AI 시스템이 개인의 프라이버시를 존중해야 한다는 원칙을 다룸. (1) 개발에 사용되는 데이터와 그 (2) 데이터로 이루어지는 결정에 대해 영향을 받는 사람들이 주체성을 포함함. 분석 대상 문서들 중 97% 문서에서 프라이버시 원칙이 포함되어 있음.

- 책임성: 이 주제는 AI 시스템의 영향을 적절하게 배분하고, 충분한 구제책을 제공하기 위한 메커니즘의 중요성을 다룸. 책임성 원칙은 97%의 문서에 포함되어 있음.

- 안전 및 보안: AI 시스템이 의도한 대로 안전하게 작동하며, 무단 접근에 취약하지 않도록 보안성을 갖추어야 한다는 요구사항을 다룸. 안전 및 보안 원칙은 81% 문서에 포함되어 있음.

- 투명성과 설명 가능성: 이 주제는 AI 시스템이 감시 가능하도록 설계되고 구현되어야 하며, 시스템의 작동을 이해할 수 있는 출력으로 변환하고, 어디에서, 언제, 어떻게 사용되는지에 대한 정보를 제공해야 한다는 원칙을 다룸. 투명성과 설명 가능성 원칙은 94% 문서에서 나타남.

- 공정성과 차별 금지: AI 편향이 이미 전 세계적으로 영향을 미치고 있는 상황에서, 공정성과 차별 금지 원칙은 AI 시스템이 공정성을 극대화하고 포용성을 증진할 수 있도록 설계되고 사용되어야 함. 이 원칙은 100% 문서에서 확인됨.

- 인간의 기술 통제: 중요한 결정이 여전히 인간의 검토를 거쳐야 한다는 내용. 이 원칙은 69% 문서에 포함되어 있음.

- 전문적 책임: 이 주제는 AI 시스템 개발과 배포에 관여하는 사람들이 시스템의 영향에 중요한 역할을 하며, 적절한 이해관계자들이 상담받고 장기적인 영향을 계획해야 한다는 원칙을 포함함. 전문적 책임 원칙은 78% 문서에 포함되어 있음.

- 인간 가치의 증진: AI가 지향하는 목적과 그것이 구현되는 방식은 우리의 핵심 가치를 반영해야 하며, 전반적으로 인류의 복지를 증진해야 한다는 원칙을 다룸. 인간 가치 증진 원칙은 69% 문서에서 나타남.

Berkman Klein Center는 각 주제에 대해, 추출된 47개의 원칙 목록을 배정하고 각 문서내에서 밀접하게 연결된 원칙들을 확인하였습니다. AI 규제에 대한 폭넓은 분석을 진행하고, 주요 원칙을 분석했다는 점에서 큰 의의를 가지고 있습니다.

Rome Call for AI Ethics (2020)

Source: https://www.romecall.org/

2020년, 로마 교황청(Roman Curia)은 인공지능(AI)에 대한 윤리적 접근을 촉진하기 위해 문서를 작성하게 됩니다. 해당 문서의 제목이 “Rome Call for AI Ethics”입니다. 이 문서의 핵심 아이디어는 국제 기구, 정부, 기관, 기술 기업이 공동 책임을 가지도록 하여, 디지털 혁신과 기술 발전이 인간의 중심적 위치를 보장하는 미래를 만들기 위합입니다.

본 문서는 빈첸조 팔리아 대주교 (교황청 생명학술원 회장), 브래드 스미스 (마이크로소프트 사장) 등의 5명이 서명하였으며, AI는 “인류 가족”(세계인권선언 서문에 언급된 개념) 전체에 봉사하고, 모든 개인의 존엄성과 자연환경을 존중하는 원칙에 따라 AI가 개발될 것을 요구합니다.

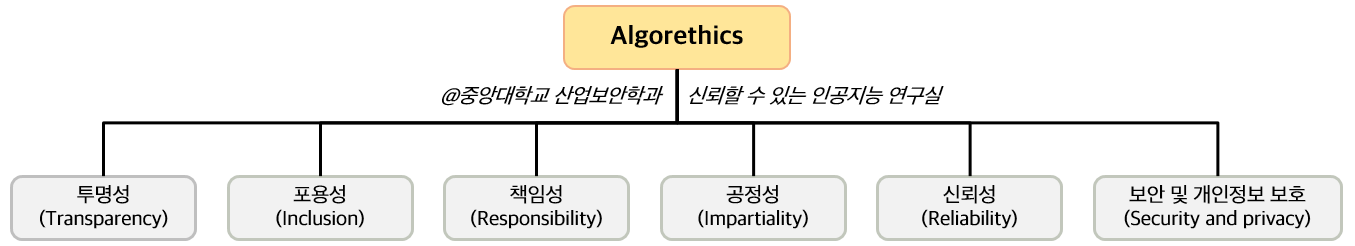

본 선언(Call)에서는 세 가지 목표(윤리, 교육, 권리)를 바탕으로, “알고리즘 윤리(algorethics)” 하의 6가지 규칙(Principles)를 제안하였습니다.

- 투명성 (Transparency): AI 시스템은 설명 가능해야 함.

- 포용성 (Inclusion): 모든 인간의 요구를 고려하여, 모두가 혜택을 누리고 각 개인이 자신을 표현하고 발전할 수 있는 최선의 조건을 제공해야 함.

- 책임성 (Responsibility): AI를 설계하고 배포하는 사람들은 책임감과 투명성을 가지고 진행해야 함.

- 공정성 (Impartiality): AI 시스템은 편견 없이 공정성을 유지하고 인간의 존엄성을 보호해야 함.

- 신뢰성 (Reliability): AI 시스템은 신뢰할 수 있는 방식으로 작동해야 함.

- 보안 및 개인정보 보호 (Security and Privacy): AI 시스템은 안전하게 작동하며 사용자의 개인정보를 존중해야 함.

EU Artificial Intelligence Act (2021)

유럽연합(EU)에서 발표한 세계 최초의 포괄적 인공지능 규제법입니다.

2021년 4월 21일에 법안이 최초로 제안된 이후로, 2024년 3월 13일 본회의에서 통과된 후 2024년 8월 1일 발효되었습니다. 2024년 12월부터 첫 조치가 시행되며, 2026년 8월에 대부분의 규정이 시행될 예정입니다.

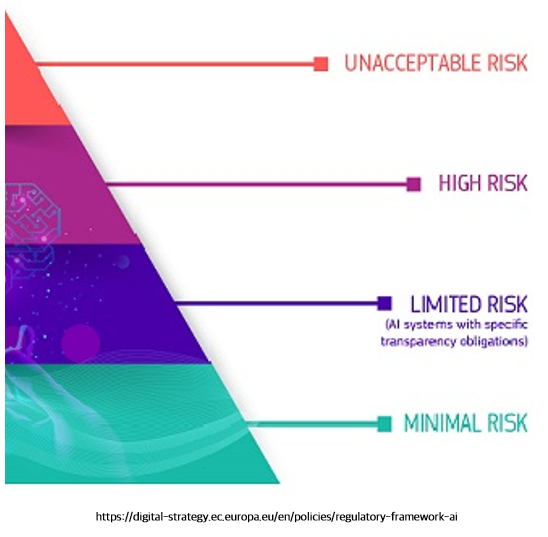

주요 특징으로는 인공지능 시스템을 위험 수준에 따라 규제하는 것입니다. 위험 수준은 총 4단계로 나뉘며, 아래와 같습니다.

이 중에서도 위의 두 시스템은 (1) 금지되거나 (2) 대부분의 규제 조항을 지켜야 합니다.

피라미드의 맨 위는 허용 불가 시스템(Prohibited AI systems)입니다. 사회적 점수 시스템 및 조작적 AI 등 아래 8가지 시스템이 해당되며, 시스템은 영구 금지됩니다.

- 의사결정 왜곡

- 특정 집단의 취약성 악용

- 사회적 평점

- 프로파일링을 이용한 범죄 예측

- 안면 인식 데이터베이스

- 직장/교육기관에서의 감정 추론

- 생체인식 분류

- 실시간 원격 생체인식 신원확인

※ 각 사항마다 예외 존재

피라미드의 두 번째는 고위험 시스템(High risk AI systems)이며 대부분의 규제 조항은 본 시스템에 해당됩니다. 크게 두 가지의 제품 및 요소가 해당 시스템으로 분류됩니다.

- EU 법령의 부속서 I에 속하는 제품 및 요소 (산업 기계, 농업 기계, 하중을 들어올리는 장비, 장난감, 라디오, 무선 기기, 고글, 마스크 등) 중 제3자 적합성 평가를 거쳐야 하는 시스템

- EU 법령의 부속서 III에 속하는 제품 및 요소: 생체인식, 중요기반시설, 교육 및 직업훈련, 근로자 관리 및 자영업에 대한 접근, 필수 민간 및 공공 서비스 혜택접근 및 향유, 법 집행, 이주, 망명 및 국경, 통제관리, 사법 및 민주적 절차 관리

※ 각 사항마다 예외 존재

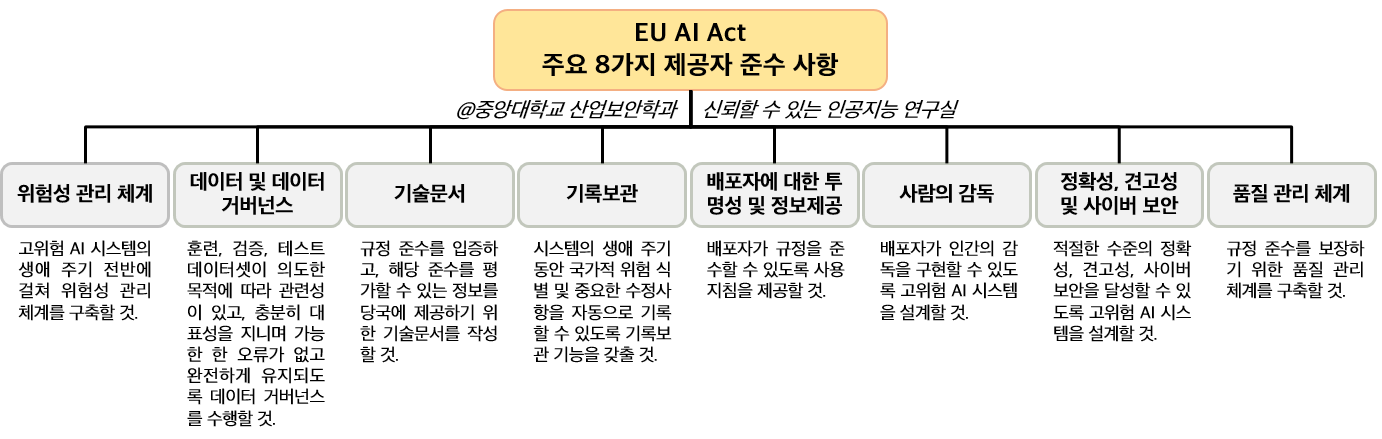

고위험 시스템을 제공하는 제공자(Provider)나 배포하는 배포자(Deployer)는 법령에 의해 다수의 의무가 부가됩니다. 이는 고위험 AI 시스템을 EU 시장에 출시하거나 서비스를 제공하려는 자에게 적용되며, 그들이 EU 내 또는 제3국에 위치하든 상관없습니다. 특히, 제공자는 가장 높은 수준의 준수 사항을 가지며, 주요 8가지 사항은 아래와 같습니다.

이 외의 기타 이해관계자(공인대리인, 수입업자, 유통업자 등)도 의무 및 준수 사항이 부과됩니다. 특히, 범용 AI (General Purpose AI, GPAI)과 관련된 이해관계자는 특별 취급되어 유럽연합의 AI 사무국의 감시를 받게 됩니다.

만약 위 의무를 다하지 않을 경우 아래 사항에 따라 벌금이 부과됩니다.

- AI 관행 금지 위반에 대한 벌금: AI 관행 금지 위반 시 최대 3,500만 유로 (525억원) 또는 전 세계 매출의 7%까지 벌금 부과 가능.

- 기타 규정 위반에 대한 벌금: 제공자, 수입자, 배포자 등 관련 규정 위반 시 최대 1,500만 유로 (225억원) 또는 전 세계 매출의 3%까지 벌금 부과 가능.

- 잘못된 정보 제공 시 벌금: 잘못된 정보 제공 시 최대 750만 유로 (112억원) 또는 전 세계 매출의 1%까지 벌금 부과 가능.

EU AI Act는 이 외에도 샌드박스 규제, AI 사무국 설립, EU 데이터베이스 설립, 모니터링 시스템 구축 등의 법을 담고 있습니다.

미국의 인공지능 규제 (USA AI Acts)

미국은 2020년 ‘국가인공지능계획(National Artificial Intelligence Initiative Act)’부터 시작하여 AI에 관한 법률을 만들어 왔습니다. 국가인공지능계획에서는 인공지능 연구 개발 및 신뢰할 수 있는 인공지능 시스템 개발을 목표로 하였으며, 자문위원회 설립 및 국립 인공지능 연구소를 설립 및 지원하였습니다.

Source: https://www.congress.gov/bill/116th-congress/house-bill/6216

이후 2022년 ‘Artificial Intelligence Training for the Acquisition Workforce Act’, 2022년 ‘Advancing American AI Act’ 등을 통해 인공지능의 훈련 프로그램 및 사용례 분석 파악을 지시하였으며, 최근 2023년 ‘Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence’에서는 미국 행정부가 안전하고 책임감 있는 AI 개발과 관리를 최우선순위로 설정하고 있음을 명시했습니다.

Source: https://www.whitehouse.gov/briefing-room/presidential-actions/2023/10/30/executive-order-on-the-safe-secure-and-trustworthy-development-and-use-of-artificial-intelligence/

본 문서에는 총 8가지의 원칙이 언급되며, 안전성과 보안, 책임 있는 혁신 촉진, 소비자 보호, 개인정보와 시민 자유 보호 등이 포함됩니다.

국내 인공지능 규제

대한민국 정부에서도 이러한 글로벌 규제 흐름에 맞추어 인공지능 관련 규제에 대한 토론, 검토가 이루어지고 있습니다. 최근 미래법제혁신기획단에서 발표한 “인공지능(AI) 관련 국내외 법제 동향”에서는 다음과 같이 정리하고 있습니다.

Source: https://www.moleg.go.kr/boardDownload.es?bid=legnlpst&list_key=3813&seq=1

- 21대 국회에서 총 13건의 인공지능 관련 법안이 발의되었고, 그 중 9건이 인공지능 자체의 진흥 및 규제 등을 목적으로 발의됨.

- 현행 법령상 ‘인공지능’이라는 문언이 규정되어 있는 법령 중 인공지능에 관하여 실질적으로 규율하고 있는 법령은 23개 (예. 개인정보 보호법, 공직선거법 등)

이 외에도 정부는 ‘인공지능 법·제도·규제 정비 로드맵 (2020.12)’, ‘금융분야 AI 가이드라인 (2021.07)’, 그리고 최근 ‘새로운 디지털 질서 정립 추진계획 (2024.05)’ 통해 국내 인공지능에 관한 규제를 적극 검토하고 있습니다.

추가적으로 합동 기관과 함께 아래와 같은 가이드라인을 제시하고 있습니다.

- 신뢰할 수 있는 인공지능 개발 안내서 (2023.02) - 한국정보통신기술협회 (과기부 「AI 신뢰성 검증체계 고도화」 사업 연구 결과)

- 챗GPT 등 생성형 AI 활용 보안 가이드라인 (2023.06) - 국가정보원 및 국가보안기술 연구소

결론

인공지능 기술이 빠르게 발전하는 오늘날, 규제의 필요성은 그 어느 때보다 강조되고 있습니다. AI가 단순히 성능 향상을 목표로 하는 것을 넘어, 인간 사회에서 신뢰할 수 있는 기술로 자리잡기 위해서는 규제의 역할이 필수적입니다. 이러한 규제들을 만족시키기 위해서는 AI 시스템이 규제의 요구를 반영하고 자체적으로 수정 및 보완할 수 있도록 인공지능 신뢰성이 달성되어야합니다.